Augmented Reality (Erweiterte Realität, AR) bedeutet, dass die Wahrnehmung der realen Welt durch virtuelle Inhalte (z. B. virtuelle Windräder) erweitert wird. Die virtuellen Objekte werden dabei in der Ansicht der realen Welt (z. B. auf dem Bildschirm eines Smartphones oder Tablets) eingeblendet und so platziert, dass es wirkt, als seien sie in der realen Welt verankert bzw. mit der realen Welt verschmolzen. Die AR-Technologie grenzt sich somit deutlich von der Technologie der Virtual Reality (Virtuelle Realität, VR) ab: Während man sich bei VR in einer vollkommen virtuellen, computergenerierten Landschaft befindet, betrachtet man bei der AR die reale Welt (z. B. durch die Kamera eines Tablets) und nur einzelne virtuelle Objekte werden positionsgetreu in diese Ansicht projiziert. Als AR-Endgeräte kommen heutzutage üblicherweise Smartphones und Tablets in Frage, die von Nutzer:innen händisch bedient und auf die reale Welt gerichtet werden können. In absehbarer Zukunft werden derartige AR-Visualisierungen jedoch auch mithilfe von AR-Brillen möglich sein.

Die heute gängigen Anwendungen mit AR-Visualisierungen finden üblicherweise eher in Innenräumen statt und blenden virtuelle Objekte in der unmittelbaren Umgebung der Nutzer:innen ein. So werden in der Praxis beispielsweise AR-Anwendungen zur virtuellen Wohnungseinrichtung eingesetzt, bei denen Möbelstücke wirklichkeitsgetreu in der Wohnung platziert werden können, oder in Museen, um Ausstellungsstücke mit animierten Inhalten digital zu erweitern. Doch auch unter freiem Himmel besitzen AR-Visualisierungen ein großes Anwendungspotenzial, z. B. um Navigationsaufgaben zu lösen oder die optischen Auswirkungen geplanter Bauvorhaben auf das Stadt- und Landschaftsbild zu visualisieren. Im Zuge der Energiewende bieten sich AR-Visualisierungen auch für geplante Freiflächen-PV-Anlagen oder Windparks an. Derartige AR-Visualisierungen im Außenbereich können als Outdoor Augmented Reality oder – sofern georeferenzierte Daten (z. B. WEA an einer bestimmten geografischen Position) dargestellt werden – als geodatenbasierte Augmented Reality (GeoAR) bezeichnet werden.

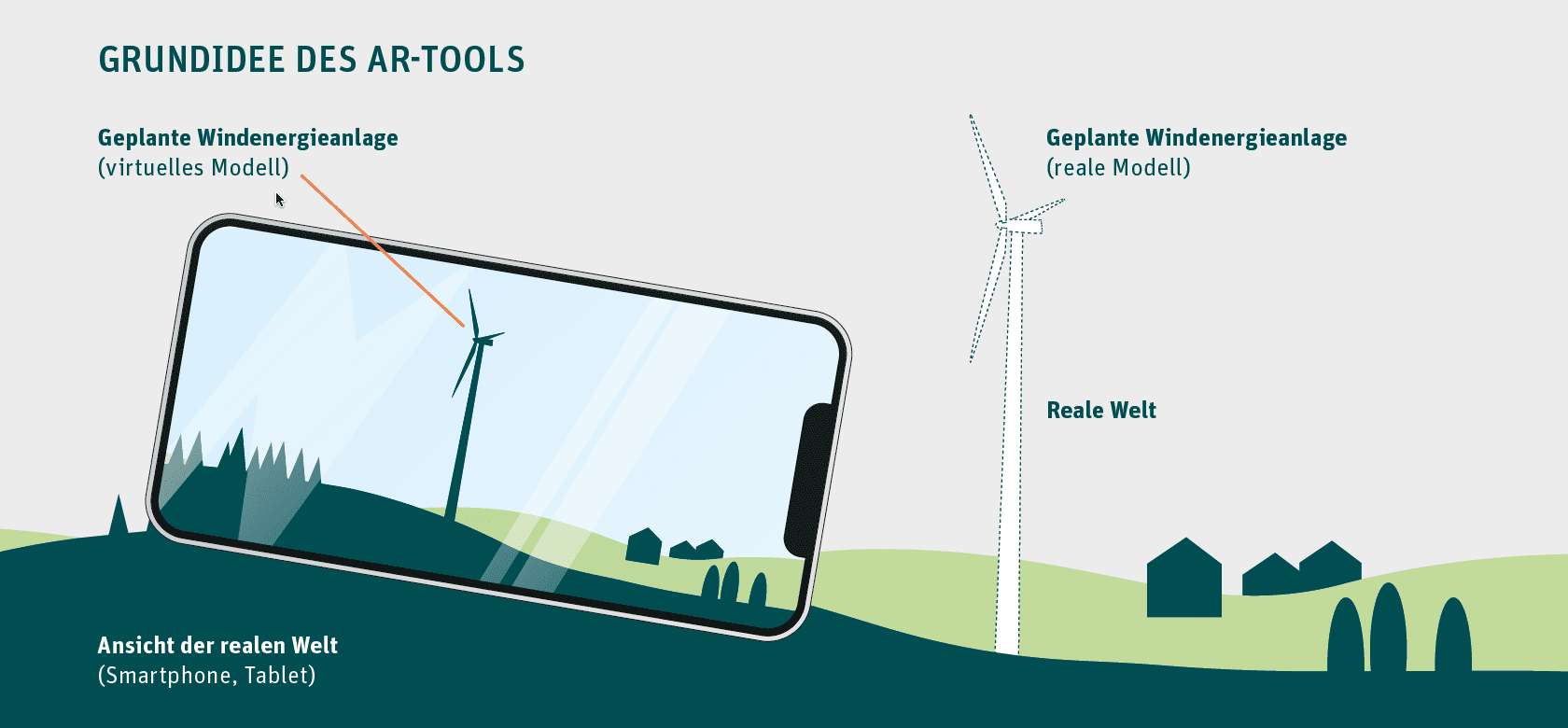

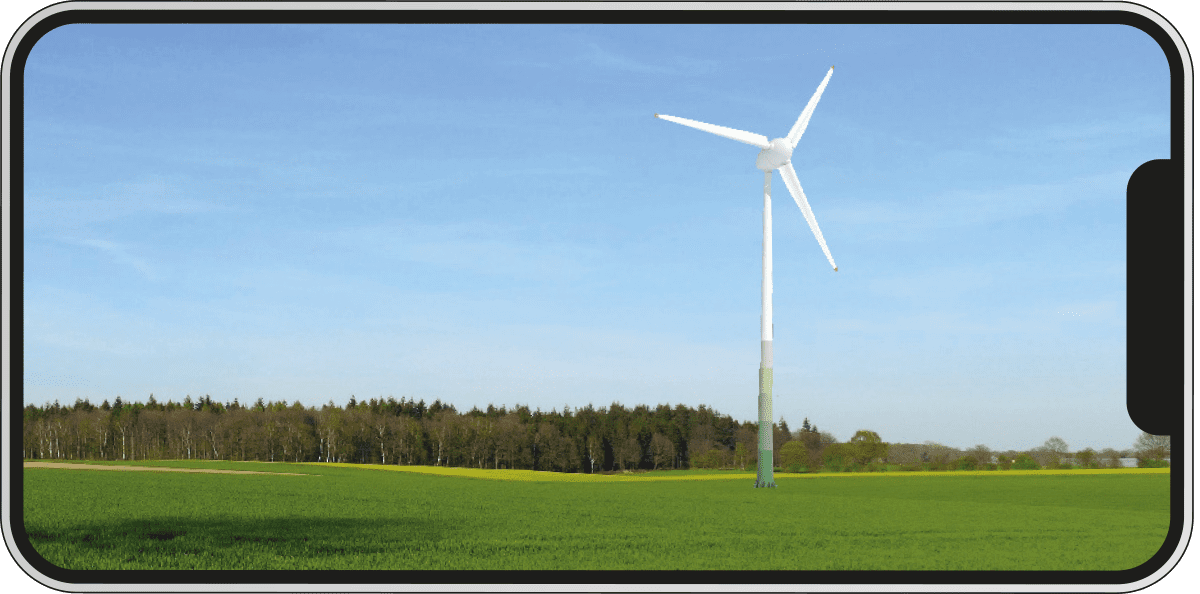

Abbildung 1:

Grundidee der Augmented Reality: Ein virtuelles Objekt (z. B. eine geplante WEA) wird in die Ansicht der realen Welt (z. B. Kameraansicht auf einem Smartphone oder Tablet) wirklichkeitsgetreu eingeblendet. Die Wahrnehmung der realen Welt wird dadurch „erweitert“.

Technische Herausforderungen bei Outdoor Augmented Reality

Damit AR-Projektionen beispielsweise von WEA im Außenbereich realitätsgetreu und korrekt dargestellt werden können, müssen einige technische Herausforderungen bewältigt werden. Dazu zählen insbesondere:

1) Präzise Geolokalisierung

2) Korrekte Wiedergabe von Verdeckungen

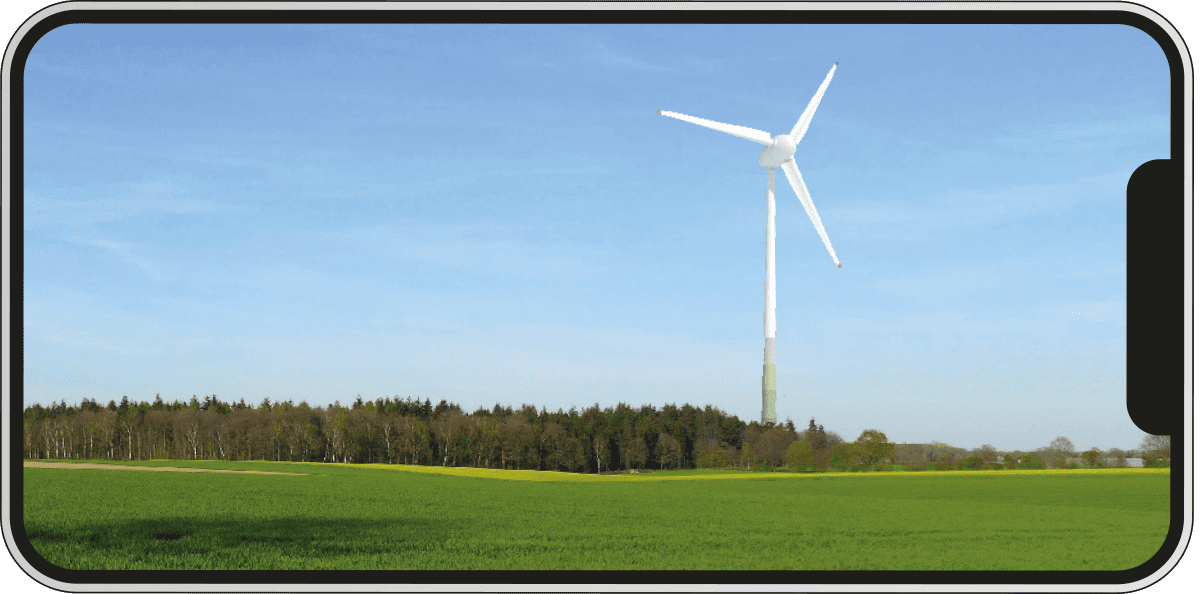

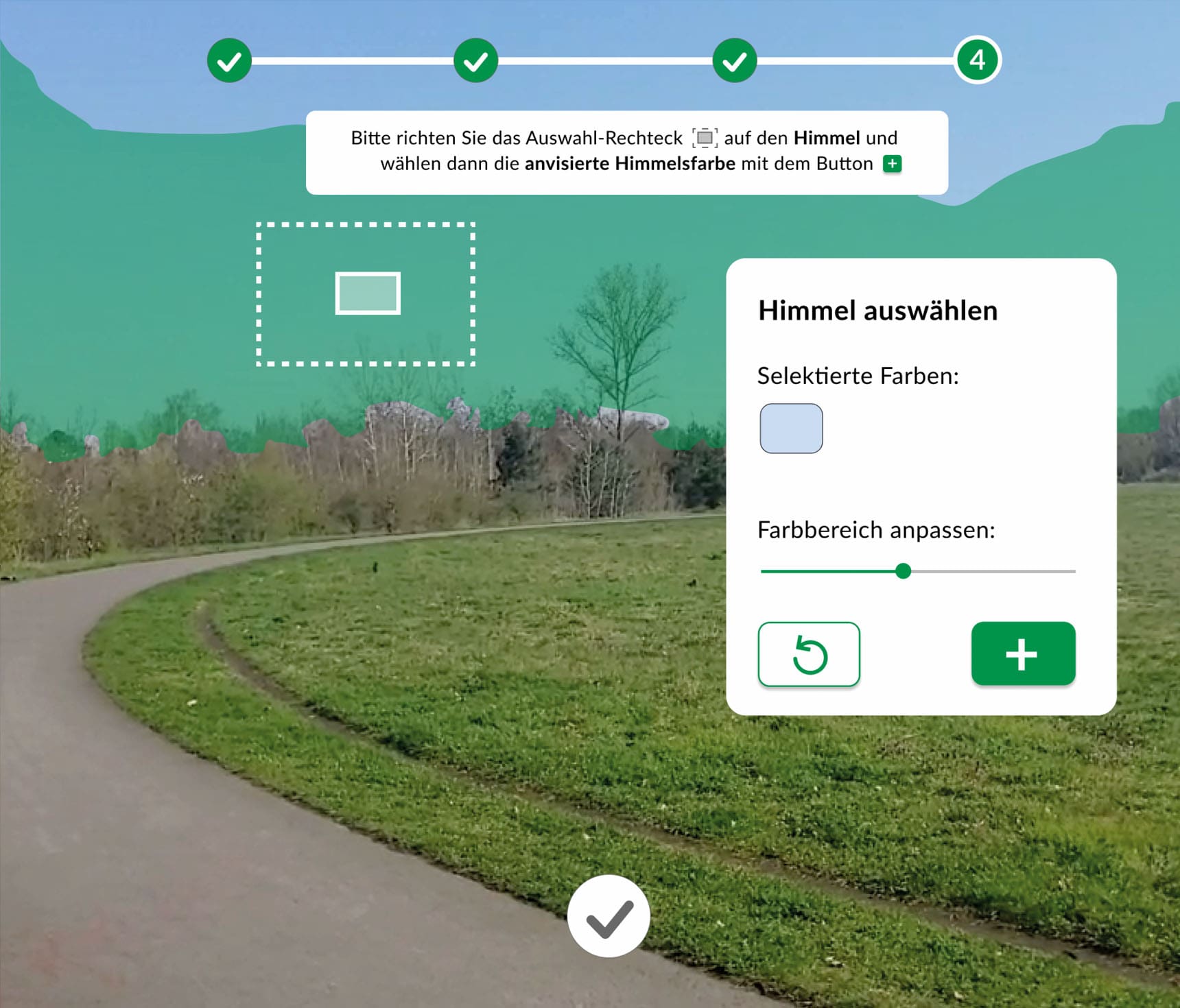

Abbildung 2:

Die wesentlichen Herausforderungen der geodatenbasierten AR-Technologie bestehen in einer präzisen Geolokalisierung des Endgeräts und in der korrekten Wiedergabe von Verdeckungen der AR-Inhalte.

- Präzise Geolokalisierung: Eine positionsgetreue Projektion der virtuellen georeferenzierten Inhalte (z. B. virtuelle Windräder) auf den Bildschirm des mobilen Endgeräts ist nur dann möglich, wenn die Position und Ausrichtung (Orientierung) des mobilen Geräts in Bezug auf ein globales geografisches Koordinatensystem korrekt und präzise bestimmt werden (Geolokalisierung). Bei ungenauer Geolokalisierung würde das virtuelle Objekt, in unserem Fall das virtuelle Windrad, an einer falschen Position auf dem Bildschirm erscheinen und eine fehlerhafte Wahrnehmung der tatsächlichen Position des Objekts in der Landschaft erzeugen. Eine präzise Geolokalisierung stellt mit dem aktuellen Stand der Technik jedoch noch eine große Hürde dar, insbesondere weil die hierfür relevanten Lokalisierungssensoren in den mobilen Endgeräten (GPS-Empfänger zur Positionsbestimmung und digitaler Kompass zur Bestimmung der Orientierung) zu ungenau sind.

- Korrekte Wiedergabe von Verdeckungen: Für eine wirklichkeitsgetreue AR-Darstellung ist neben einer präzisen Lokalisierung auch die korrekte Wiedergabe von Verdeckungen der virtuellen Objekte notwendig. Virtuell platzierte Windräder können beispielsweise durch Vegetation, Gelände oder Gebäude verdeckt werden. Werden Verdeckungen nicht korrekt berücksichtigt, so werden die virtuellen Windräder lediglich auf das Kamerabild gelegt und nicht in das reale Landschaftsbild eingefügt. Dies führt ebenfalls zu einer fehlerhaften Wahrnehmung der Positionierung und des Erscheinungsbilds der geplanten Anlage. Mithilfe der in mobilen Endgeräten integrierten Sensoren kann üblicherweise jedoch nur die unmittelbare Umgebung digital erfasst und rekonstruiert werden. Eine Berücksichtigung von entfernten Verdeckungen (z. B. durch Wald oder entfernte Gebäude) ist somit nicht ohne Weiteres möglich.

„Die Visualisierung war beeindruckend und hilfreich, insbesondere bezüglich der Auswirkungen verschiedener Standorte auf das Landschaftsbild.

Die bodennahe Drehbewegung der Rotoren an einem Standort hat jedoch Bedenken hinsichtlich des Artenschutzes geweckt. Ich befürchte höhere Verluste für die gefährdeten Vogel- und Fledermausarten, die diese niedrigen Höhen bevorzugen.“

Dr. Michael Pacyna, Vorsitzender eines Artenschutzvereins

Wie lösen AR-Tools die Herausforderungen?

Die Bewältigung dieser beiden Herausforderungen kann auch als Prozess der Kalibrierung (GeoAR-Kalibrierung) bezeichnet werden. Bevor eine korrekte AR-Abbildung der geplanten Windräder vor Ort möglich ist, muss das AR-System (Smartphone, Tablet) im Zuge einer Kalibrierung einmalig so justiert werden, dass eine genaue Lokalisierung und eine korrekte Wiedergabe von Verdeckungen möglich ist.

In der Theorie könnte eine solche Kalibrierung durch Verfahren der Bildanalyse und Bilderkennung vollautomatisch gelöst werden. Diese automatischen Kalibrierungsansätze basieren auf großen, vorab aufgenommenen und qualitativ hochwertigen 3D-Referenzmodellen (3D-Punktwolken) des gesamten Anwendungsgebiets, in dem AR-Visualisierungen ermöglicht werden sollen. Die Vorab-Erstellung solcher 3D-Referenzmodelle ist jedoch sehr ressourcen- und kostenintensiv bzw. nur in ausgewählten Gebieten (z. B. entlang von öffentlichen Straßen) realisierbar.

Als geeignete Alternative bieten sich manuelle, nutzergesteuerte Methoden an, um eine präzise Geolokalisierung zu ermöglichen und Verdeckungen in der Ferne zu berücksichtigen. Zu diesem Zweck konnten daher im Rahmen des Forschungsprojektes ar4wind die folgenden zwei nutzergesteuerten Kalibrierungsmethoden entwickelt und in der Praxis eingesetzt werden:

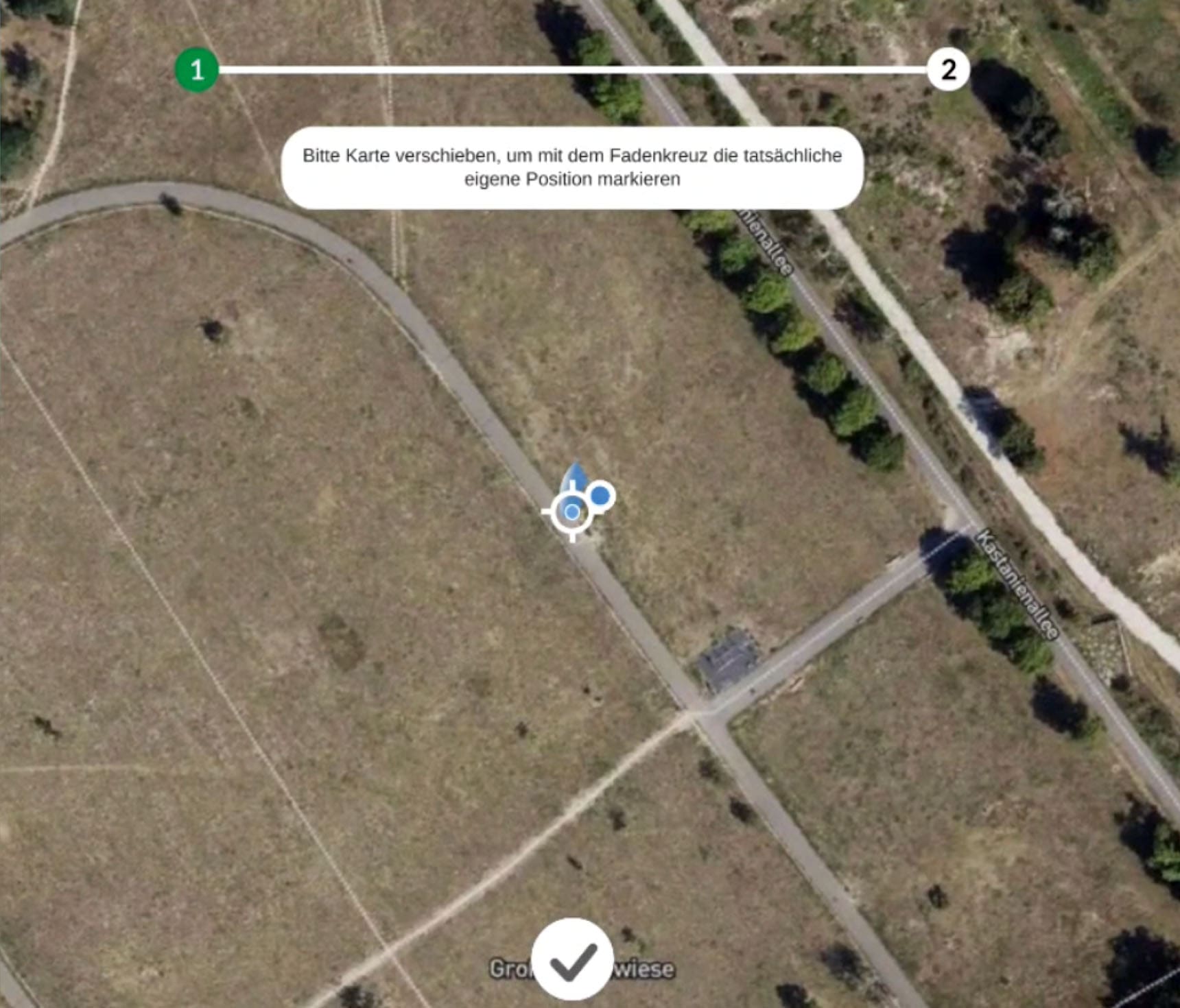

A) Kalibrierung mit Referenzpunkt und Himmel-Segmentierung:

In einer Kartenansicht präzisieren die Nutzer:innen der AR-Anwendung zunächst manuell die eigene Position. Anschließend legen sie einen sichtbaren Referenzpunkt in der Umgebung fest (z. B. Kirchturm, Hausdach, Hochspannungsmast). Dieser Referenzpunkt dient zur Justierung der Blickrichtung, indem eine Referenzlinie in der realen Kameraansicht (AR-Ansicht) auf die tatsächliche Position des ausgewählten Objektes geschoben wird. Zur Wiedergabe von Verdeckungen wird der Himmel farbbasiert segmentiert und maskiert. Dazu wählen die Nutzer:innen in der Kameraansicht manuell Farbbereiche des Himmels aus. Die virtuellen Windräder sind dann nur in diesem maskierten Bereich des Himmels sichtbar, während sie im „Nicht-Himmel“-Bereich von der Landschaft verdeckt werden.

B) Kalibrierung mithilfe von 3D-Landschaftsmodellen:

Alternativ können auch digitale 3D-Landschaftsmodelle zur Kalibrierung genutzt werden. Auch in diesem Verfahren bestimmen die Nutzer:innen ihre eigene aktuelle Position zunächst manuell über eine Kartenansicht. Anschließend werden digitale 3D-Landschaftsmodelle (z. B. texturierte Oberflächenmodelle) als optische Hilfsmittel in der Kameraansicht eingeblendet. Per Interaktionsgesten können die Nutzer:innen diese Modelle so verschieben, dass sie mit der realen Landschaft übereinstimmen. Dadurch erfolgt eine korrekte Justierung der Blickrichtung. Diese digitalen Landschaftsmodelle dienen anschließend auch als wirklichkeitsgetreue Verdeckungsobjekte der virtuellen WEA.

Beide Kalibrierungsmethoden können im Kontext der AR-Visualisierung von geplanten WEA in der Praxis zum Einsatz kommen. Die technische Realisierung und Bereitstellung des zweiten Verfahrens (Kalibrierungsmethode B) ist komplexer, da entsprechende 3D-Landschaftsmodelle zunächst in geeignete Formate umgewandelt werden müssen, um effektiv in die AR-App integriert werden können. Außerdem sind derartige 3D-Landschaftsmodelle nicht für alle Gebiete gleichermaßen öffentlich und kostenfrei verfügbar.

Ist dies jedoch gegeben, stellt dieses Verfahren eine schnelle, intuitive und nutzerfreundliche Möglichkeit der Kalibrierung dar. Die erste Methode (Kalibrierungsmethode A) ist hingegen etwas zeitaufwändiger und mühsamer in der Bedienung, sie kann jedoch ohne allzu umfangreichen Vorab-Einrichtungsaufwand räumlich flexibel in beliebigen Anwendungsgebieten zum Einsatz kommen. Idealerweise könnte für jeden Einsatzort individuell entschieden werden, welche Methode der Kalibrierung vorzugsweise genutzt werden soll.

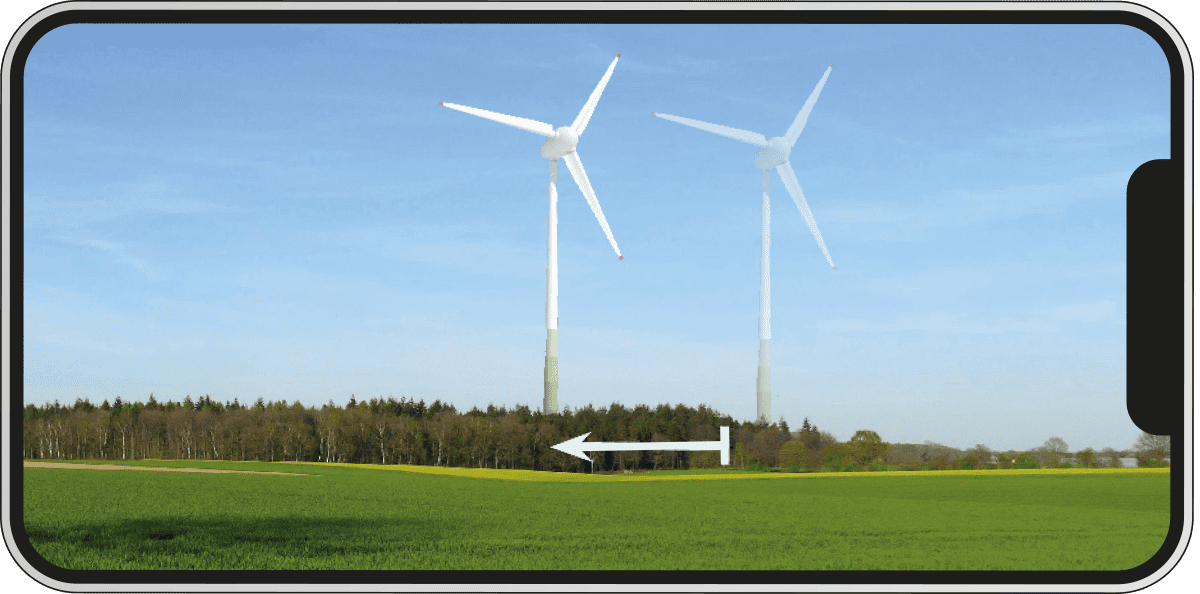

A) Kalibrierung mit Referenzpunkt und Himmel-Segmentierung

B) Kalibrierung mithilfe von 3D-Landschaftsmodellen

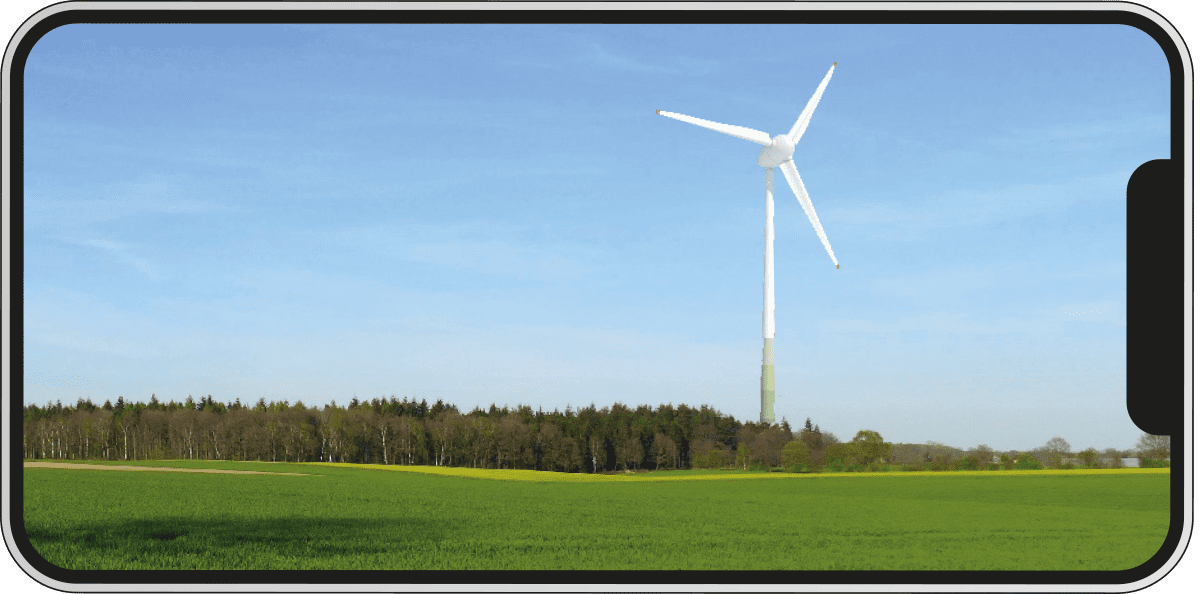

Finale AR-Visualisierung

Finale AR-Visualisierung

Abbildung 3:

Die Kalibrierung des AR-Geräts ist für eine realitätsgetreue Einblendung der virtuellen WEA mit korrekter Wiedergabe von Verdeckungen notwendig. Sie kann auf unterschiedlichem Weg erfolgen, entweder mithilfe von manuell gesetzten Referenzpunkten in der Umgebung und einer farbbasierten Segmentierung des Himmels (Kalibrierungsmethode A) oder durch Verschieben von virtuellen 3D-Landschaftsmodellen (Kalibrierungsmethode B).